На прошлой неделе Apple выпустили бета-версию iOS 13.2 в которой стала доступна новая революционная технология Deep Fusion, улучшающая фото. Результаты первых тестов получились неоднозначными, вроде бы стало лучше, а вроде бы это совсем чуть-чуть заметно.

Поэтому мы решили разобраться, что это за зверь такой и вообще кому Deep Fusion нужен. Что на самом деле делает эта технология и есть ли в ней смысл?

Как работает?

Начнём с того зачем вообще понадобилась новая технология и что она делает? Если спросить большинство пользователей Apple, они ответят: делает красиво! На самом деле все это работает весьма интересно!

ЭТАП 1

Еще до того как вы нажали на кнопку затвора, в циклическом буфере вращается 8 фотографий: 4 с короткой выдержкой, чтобы заморозить движение и 4 с нормальной.

Плюс ко всему, после нажатия кнопки затвора, делается ещё один снимок, с длинной выдержкой и соответственно яркой экспозицией.

ЭТАП 2

Далее из снимков с короткой выдержкой выбирается наиболее удачный, он становится референтным кадром из которого будут браться контуры и информация о светлых участках. Пока это всё очень напоминает то как делает снимки Pixel со своим HDR+, но вот дальше Apple начинает удивлять.

ЭТАП 3

Дальше, из трех кадров с нормальной выдержкой и одного с длинной каким-то волшебным образом создаётся, так называемый, синтетический длинный снимок. В котором мало шума и есть информация в тенях.

ЭТАП 4

В завершение начинается какое-то вычислительное нейронное пиксельное соитие от Apple: склеиваются референсный и синтетический длинный снимок.

Но самое интересное вот что. Различным участкам этих кадров присваивается один из четырёх уровней детализации. Однотонные области, такие как небо, стены, и прочее — получают наименьший уровень, а, например, кожа, волосы, ткани — наивысший.

Потом оба снимка сливаются воедино, причём необычно: из одного одного снимка берутся только детали, а из другого — цвет, тон и яркость.

Начнём с натюрморта

На первый взгляд снимки одинаковые, но если присмотреться можно заметить, что ковер и нитки в нижнем правом углу выглядят заметно детальнее на фотографии справа.

С другой стороны, если посмотреть на синюю папку на обычной фотографии текстура однородная, а на фотографии с Deep Fusion видно, что какие-то участки детальные, а какие-то размытые. Тоже самое с чёрной тканью в центре кадра (посередине такая размазня).

Видимо, это как раз следствие разбивки фотографии на 4 уровня детализации. Какому-то участку кадра везет, а какому-то нет. Пока что алгоритм в бета-версии, тем более на этой фотографии чуть по разному сработал автофокус, поэтому не будем судить строго. Погнали дальше.

Следующее фото сделано с той же точки на телеобъектив.

Если не приближать снимок, полученный с помощью Deep Fusion фотография выглядит заметно детальнее, контрастнее, лучше видны текстуры. Но если увеличить видно что, всё не так однозначно.

Синяя папка всё также неравномерно размыта, тут явно проблема не в автофокусе, просто так работает алгоритм.

А если посмотреть на текст комикса видно, что разрешение на Deep Fusion фотографии существенно ниже чем на обычной.

Результат неоднозначный, с одной стороны разрешение упало, но с другой, если не увеличивать, фотография с Deep Fusion выглядит интереснее.

Вот ещё пара примеров с телеобъектива. В обоих случаев фотографии с Deep Fusion выглядят немного контрастнее, но в целом мало чем отличаются от Smart HDR.

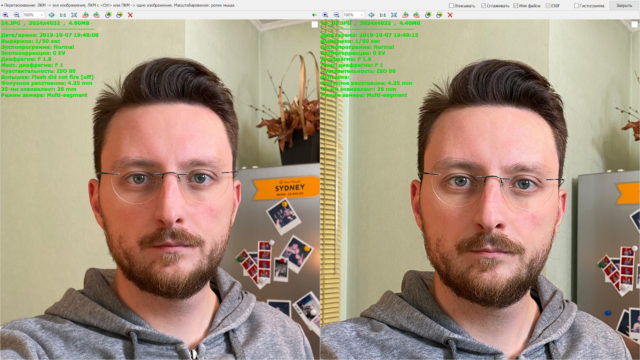

Теперь перейдём к портретам.

И вот тут выясняется интересный момент. Несмотря на заявление Apple, что Deep Fusion должен работать при среднем освещении, на практике выяснилось, что при обычном комнатном освещении он не включается. Не говоря уже про уютный свет в любимом баре.

Deep Fusion начинает работать только при довольно ярком искусственном освещении или на улице в пасмурную погоду. В более темных сценариях начинает работать ночной режим.

В текущей бете не так легко понять, что Deep Fusion используется в конкретном снимке. Для этого надо сразу после съемки открыть фотку, и если она будет обрабатываться и чуть изменится, значит функция активировалась.

Причем, чем ярче освещение тем больше заметен эффект. Вот пример портретов на телеобъектив.

Довольно тусклый свет, ISO 500:

Это нижняя граница, при которой Deep Fusion включается, но никаких преимуществ по сравнению со Smart HDR не даёт.

Но уже на ISO 400 Deep Fusion уже существенно вырывается вперед.

С увеличением количества света отрыв нарастает.

ISO 200:

ISO 125

ISO 100

ISO 80

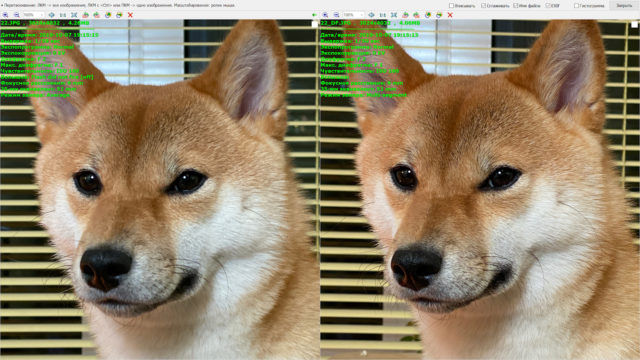

Разница заметна ещё больше при съемке на основной широкоугольный модуль.

Становится видно текстуру кожи, каждую морщинку, каждый волосок. Начинаешь замечать, что стареешь, ценить каждый момент. Думать, как там у мамы дела, давно не звонил… А ещё собака лучше получается на фотографиях.

Если интересно подробнее посравнивать, то вот вам ссылка на примеры в оригинальном качестве плюс несколько фотографий с Pixel для сравнения.

Для ярких дневных сцен в солнечной Калифорнии в iPhone есть Smart HDR. Для ночной фотографии — ночной режим. А вот для глубокой проработки деталей в условиях среднего освещения придумали Deep Fusion.

Идеально для нашей пасмурной осени, любви к свитерам и коврам. Спасибо Apple, что не забываете про Россию матушку!

Заключение

В итоге, технология Deep Fusion выглядит многообещающу, но очевидно пока она недоработанная. Apple позже всех игроков подключилась к гонке вычислительной фотографии и сейчас всеми силами показывает, что они настроены серьёзно. А это здорово для развития отрасли в целом! Будем надеяться, что к выходу Pixel 4 они допилят технологию, а мы сделаем эпичное сравнение.

Огромное спасибище за помощь в работе над материалом Антону Евстратенко.